In Arbeit: Stand der KI-Technik, Version 0.7.0, 2. November 2025

Alles aus eigener Erfahrung mit viel Liebe zu praktischen Details

bei großer Informationsdichte

Keine Werbung, keine Affiliate-Links, keine bezahlten Inhalte

Tips aus dutzenden der besten Quellen für Ihren schnellen, professionellen Einstieg

in Künstliche Intelligenz

Allerhöchste Zeit, dass Unternehmen, gleich welcher Größe, KI nutzen,

um nicht den Anschluss zu verlieren.

Webseite mit Hilfe von VS Code mit Git, GitHub, GitHub Copilot, ChatGPT und Chrome Entwicklertools

Generative KI, nach Internet und Smartphone die nächste eierlegende Wollmilchsau:

OpenAI ChatGPT, ein Microsoft Copilot, Google Gemini oder Anthropic Claude

je nachdem, in welchem (Office-) Ökosystem Sie sich bewegen

Denkend, Agenten die im Web browsen, spezialisiert auf Programmierung,…

▶

GPT — multi-modales generatives Sprachmodell und Zwillings-Angebote von Microsoft; Konkurrenz-Angebote von Google (Gemini) und Anthropic (Claude)

Text-zu-Sprache, das (fast) alles versteht (sogar mit wenig Kontext)

Bild- und Videogeneratoren, die aus jedem Kritzler einen Künstler machen

"Data Analyst" für atemberaubende Auswertungen

Programmgierassistenten

Text-zu-Sprache mit Emotion — von Menschen nicht mehr zu unterscheidenSeit einem Jahr vieles kostenlos, anscheinend um die Gunst der Stunde zu nutzen ein möglichst breites Publikum schnellstmöglich zu gewinnen.

Kopf-an-Kopf-Rennen zwischen OpenAI, Google, Anthropic und xAI und herausgefordert von Open-Source-Modellen von DeepSeek, Qwen und einem halben Dutzend anderer.

(Google) DeepMind muss man zugute halten, dass sie Modelle heraus bringen, die in ganz anderen Ligen spielen und oft den Mitbewerb (ob menschlich oder konventionelle Programmierung) wesentlich übertreffen.

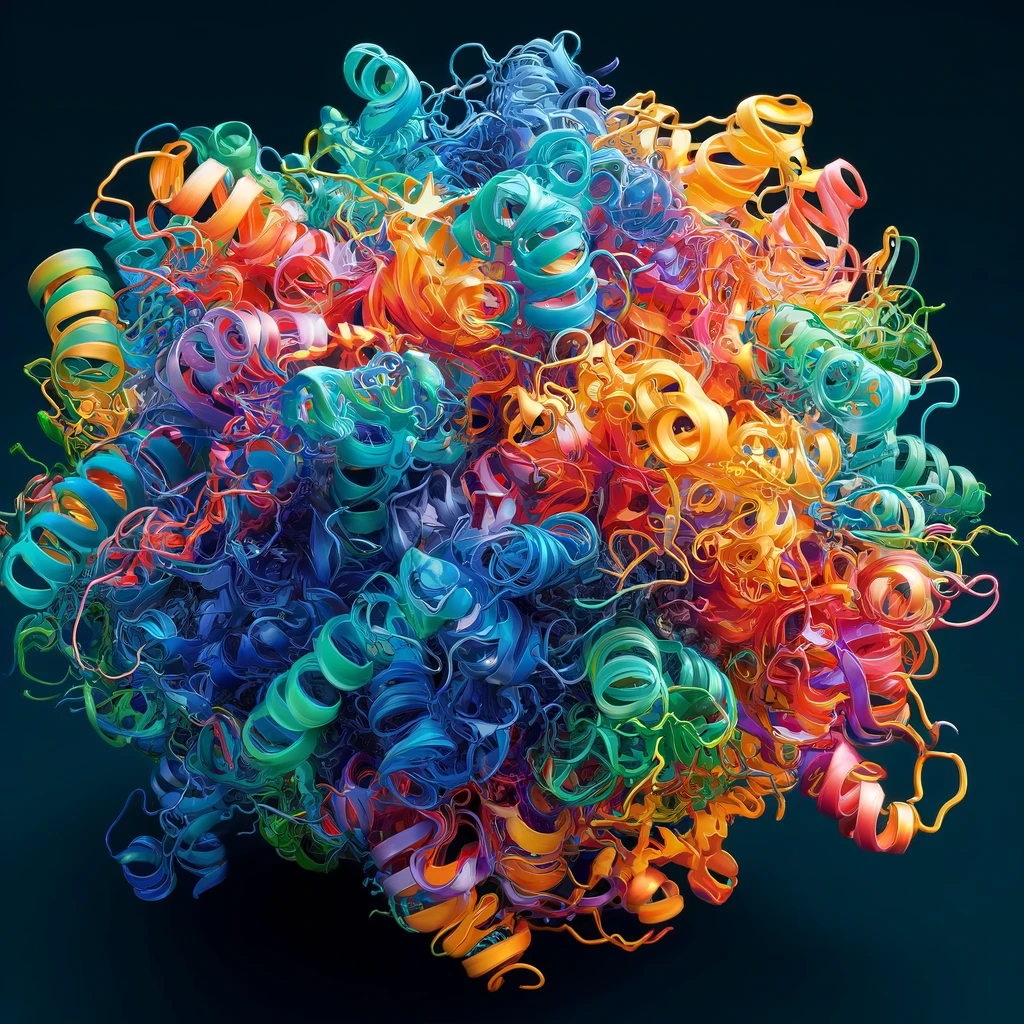

(AlphaFold Proteinfaltung und mehr, Wettermodelle mit um Größenordnungen besserer Effizienz,…)

Seite in Arbeit...

MS Github Copilot & OpenAI ChatGPT Modelle oder Anthropic Claude mit Code "canvases",… ▶

Auch wenn Klickköder-Schlagzeilen das Gegenteil suggerieren: Open Source lokal ausgeführt ist meist Zweiter

Damit ein lokales Modell ähnlich gut ist, muss es derzeit deutlich jenseits 13b Parameter sein. Dann ist es aber auf normaler Hardware relativ langsam.

Aber schon die verbesserte Idee: Continue Plugin für VS Code und Ollama Umgebung für eine Modell-Combo (Codestral 22b Chat und "fill in the middle", Llama 3 7b v 70b und Starcoder 2)

Wenn der Code nicht Firmengeheimnis ist, lässt man sich von ChatGPT 4o gratis verwöhnen und / oder riskiert einen $-Zehner für GitHub Copilot

Open Source Modelle auf Hugging Face von Meta (Llama), Mistral, AI2 (Olmo)

ausgeführt in LM Studio, Ollama oder GPT4All

▶

bullet

p

bullet

text

text

RAG Retrieval Augmented Generation um nicht-öffentliche Daten in eines der großen KI-Modelle einzubinden ▶

Google NotebookLM

p

RAG via GUI oder Framework (z.B. LlamaIndex)

text

text

Prompt "Engineering" ▶

Einfache Gemüter priesen "prompt engineering" als den Zukunftsjob — als ob es nicht für jeden logisch denkenden Menschen vollkommen klar hätte sein müssen, dass LLMs selbst dafür prädestiniert waren.

Prompt generation support in OpenAI chatGPT playground

The Generate button in the Playground lets you generate prompts, functions, and schemas from just a description of your task.

h4

p text br

text -p

Nvidia Digitale Zwillinge in Omniverse ▶

Digitale Zwillinge (von Robotern, Fabriken und schließlich der Erde)

zur Planung und / oder Wartung (Abgleich Realität v Modell in Echtzeit)

Roboter (verschiedene Anbieter) mit Nvidia Isaac Sim zu Dutzenden im Extrem-Zeitraffer trainieren und natürlich-sprachlich befehligen

BMW ist ein alt-bekanntes Nvidia Vorzeigebeispiel für den digitalen Fabrikszwilling

Spezialmodelle wie Google Deepmind MedLMs, AlphaFold ▶

bullet

p

bullet

text

text

KI-Beschleuniger: Nvidia GPUs oder Apple Silicon M-Serie-Prozessoren mit Unified Memory

oder AMD GPU mit 128GB HBM3e, Groq oder 1TB CXL virtueller Speicher

▶

KI-Beschleuniger "Landschaft in Bewegung"

Im Oktober 2023 beschloss ich, einen erweiterbaren Rechner zum Probieren für lokale KI-Modelle zusammen zu bauen, bei dem die Komponenten wirklich verfügbar waren und kein Vermögen kosteten.

Intel Xeon 112 PCIe 5 Lanes (6x 16bit Erweiterungsslots + 1x8bit), 256GB DDR5, 2x Nvidia RTX 4000 20GB GDDR5 (mit 1-Slot-Design ausbaubar bis zu 6 Stück), relativ zur Performance viel VRAM, verfügbar, bezahlbar), NVMe PCIe 4 SSDs (PCIe 5 SSD = Stromfresser)

Im Dezember 2023 entdeckte ich das MacBook Pro M3 mit 36GB Unified Memory und schickte mein Intel-MacBook in Pension.bullet

text

text

Weniger sinnvolle Anwendungen, oft kritiklos nachgebetet ▶

KIs sollten alles allein aus Beispielen lernen und scheiterten kläglich an Grundrechnungsarten.

Allmählich dürfen / können sie wie Schüler sozusagen Werkzeuge benutzen.

Wie Studenten Prüfungen mit Hilfe von Mitschriften und Skripten bewältigen (neudeutsch: open book), können KIs sich des Internet bedienen.KI-Agenten (sehr modern!) für Wetterauskunft mit der Aussagekraft / Vieldeutigkeit von Icons für "wechselhaft" und einer Trefferwahrscheinlichkeit wie bei Aprilwetter

Seit Jahren dieselben Beispielfragen an Siri, Google und Alexa, wie:

Wie ist (wird?1)) das Wetter? (1) Deutsche Sprache, schwere Sprache!)

Die einzig gute Antwort hatte Amazon vor Jahren mit einem TV-Spot-Sicker-Witz, wo sich der aufmerksame Beobachter fragt, warum der Darsteller nicht beim Fenster hinaus schaut.

Ahh, er ist blind! Und da ist auch die Fragestellung korrekt.1)KI — in vielen Bereichen auf Uni-Niveau — oft missbraucht für Alltagsplattitüden oder blanken Unsinn, im Dutzend als Beispiele auf Startseiten von Chatbots

"Erkläre das Konzept der Nostalgie einem Vorschulkind"

Logikaufgaben sprachlich maximal verklausuliert

Vereinfacht: Drei Mörder. Ein Mörder kommt dazu und ermordet einen Mörder. Wieviele Mörder sind da?

Drei? Vier? (Zählt ein toter Mörder als Mörder?)Vereinfacht: Mary travelled to the kitchen. Sandra journeyed to the kitchen. Mary went back to the garden. Where is Mary?

Llama3-8B-1.58-100B-tokens versteht es falsch. ChatGPT 4o weiß, dass "travelled" und "journeyed" die falschen Ausdrücke sind.

Doppelte Vernebelung? Muss KI jedes Sprachkonvolut verstehen können?